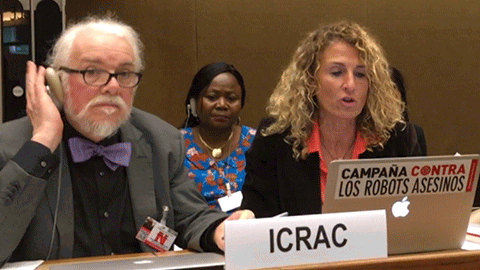

Professors de l’Escola llegeixen una declaració de l’ICRAC durant la Convenció sobre Certes Armes Convencionals de l'ONU

28/11/2018

Després de la publicació del seu llibre "Inteligencia artificial y armas autónomas letales", els professors Roser Martínez i Joaquín Rodríguez han participat novament a la reunió d'Experts governamentals de l'ONU en el marc de la Convenció sobre Certes Armes Convencionals per prohibir els anomenats Killer Robots o robots autònoms letals. L'esdeveniment va tenir lloc els dies 21, 22 i 23 de novembre, al Palau de les Nacions de Ginebra.

Com a membres del Comitè Internacional pel Control d’Armes Robòtiques (ICRAC), els professors varen ser escollits per llegir una declaració oficial del comitè durant el plenari de les Nacions Unides, en què també hi participaven altres entitats no governamentals i representants dels països.

En la declaració, l’entitat no governamental afirmava que hi ha més comprensió sobre els reptes que suposen els sistemes d’armament autònom, però que cal plasmar aquest consens general en mecanismes legals vinculants que restringeixin l’ús d’armament autònom sense un control humà en decisions crítiques.

El conjunt d’acadèmics i experts en seguretat han estat durant tot l’any produint un gran nombre d’articles científics, llibres i informes, en els quals s’hi han identificat tres riscos principals:

Primer, que aquestes armes “no poden garantir el compliment del dret internacional humanitari”, perquè les noves tecnologies en Intel·ligència Artificial encara plantegen problemes en algoritmes de decisió i reconeixement facial.

Segon, que els valors morals o el respecte a la dignitat humana no estan garantits per cap màquina, pel què un robot no és capaç de decidir si és legítim acabar o no amb la vida del seu objectiu.

I, en tercer lloc, que “els sistemes d’armament autònom són un perill per a la seguretat global”, ja que el desenvolupament i ús d’aquests robots sense restricció “incentivarà la seva proliferació, inclòs per part d’actors que no són responsables davant els marcs legals que regeixen l’ús de la força”.

Des de la coordinació de la campanya Stop Killer Robots, consideren que l’encontre no ha tingut bons resultats: “estem consternats que els països no puguin posar-se d’acord sobre un mandat més ambiciós per prevenir el desenvolupament d’armes totalment autònomes”, ha apuntat la seva responsable, Mary Wareham (Human Rights Watch).

Els estats han coincidit que cal seguir mantenint converses diplomàtiques sobre els sistemes d’armament autònoms, tot i que s’han reduït el nombre de sessions. Al març i a l’agost, es reprendran els diàlegs, dels quals en sortirà una decisió final al novembre de 2019.