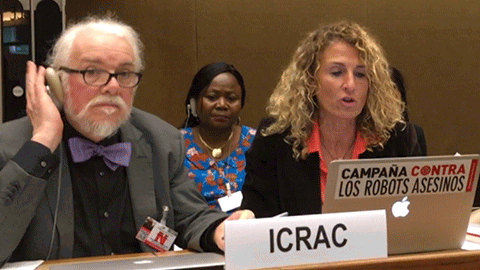

Profesores de la Escuela leen una declaración del ICRAC durante la Convención sobre Ciertas Armas Convencionales de la ONU

28/11/2018

Después de la publicación de su libro "Inteligencia artificial y armas autónomas letales", los profesores Roser Martínez y Joaquín Rodríguez han participado nuevamente en la reunión de expertos gubernamentales de la ONU, en el marco de la Convención sobre Ciertas Armas Convencionales para prohibir los llamados killer robots, o robots autónomos letales. El acontecimiento tuvo lugar los días 21, 22 y 23 de noviembre, en el Palacio de las Naciones de Ginebra.

Como miembros del Comité Internacional para el Control de Armas Robóticas (ICRAC), los profesores fueron escogidos para leer una declaración oficial del comité durante el plenario de las Naciones Unidas, en la que también participaban otras entidades no gubernamentales y representantes de los países.

En la declaración, la entidad no gubernamental afirmaba que hay más comprensión sobre los retos que suponen los sistemas de armamento autónomo, pero que hay que plasmar este consenso general en mecanismos legales vinculantes que restrinjan el uso de armamento autónomo sin un control humano en decisiones críticas.

El conjunto de académicos y expertos en seguridad han ido durando todo el año produciendo un gran número de artículos científicos, libros e informes, en los cuales se han identificado tres riesgos principales:

Primero, que estas armas “no pueden garantizar el cumplimiento del derecho internacional humanitario”, porque las nuevas tecnologías en Inteligencia Artificial todavía plantean problemas en algoritmos de decisión y reconocimiento facial.

Segundo, que los valores morales o el respeto a la dignidad humana no están garantizados por ninguna máquina, por lo que un robot no es capaz de decidir si es legítimo acabar o no con la vida de su objetivo.

Y, en tercer lugar, que “los sistemas de armamento autónomo son un peligro para la seguridad global”, puesto que el desarrollo y uso de estos robots sin restricción “incentivará su proliferación, incluido por parte de actores que no son responsables ante los marcos legales que rigen el uso de la fuerza”.

Desde la coordinación de la campaña Stop Killer Robots, consideran que el encuentro no ha tenido buenos resultados: “estamos consternados de que los países no puedan ponerse de acuerdo sobre un mandato más ambicioso para prevenir el desarrollo de armas totalmente autónomas”, ha apuntado su responsable, Mary Wareham (Human Rights Watch).

Los estados han coincidido en que hay que seguir manteniendo conversaciones diplomáticas sobre los sistemas de armamento autónomos, a pesar de que se han reducido el número de sesiones. En marzo y en agosto, se retomarán los diálogos, de los cuales saldrá una decisión final en noviembre de 2019.